比如hostloc的robots是这样的

- #

- # robots.txt for Discuz! X3

- #

- User-agent: *

- Disallow: /api/

- Disallow: /data/

- Disallow: /source/

- Disallow: /install/

- Disallow: /template/

- Disallow: /config/

- Disallow: /uc_client/

- Disallow: /uc_server/

- Disallow: /static/

- Disallow: /admin.php

- Disallow: /search.php

- Disallow: /member.php

- Disallow: /api.php

- Disallow: /misc.php

- Disallow: /connect.php

- Disallow: /forum.php?mod=redirect*

- Disallow: /forum.php?mod=post*

- Disallow: /home.php?mod=spacecp*

- Disallow: /userapp.php?mod=app&*

- Disallow: /*?mod=misc*

- Disallow: /*?mod=attachment*

- Disallow: /*mobile=yes*

复制代码

—————————————————–

需要屏蔽 MJ12bot 与 YandexBot 这些爬的网站都跑不动了。

求帮助~~

湖南网友:

- #

- # robots.txt for Discuz! X3 P Inc.

- #

- User-agent: *

- Disallow: /api/

- Disallow: /data/

- Disallow: /source/

- Disallow: /install/

- Disallow: /template/

- Disallow: /config/

- Disallow: /uc_client/

- Disallow: /uc_server/

- Disallow: /static/

- Disallow: /admin.php

- Disallow: /search.php

- Disallow: /member.php

- Disallow: /api.php

- Disallow: /abc*/

- Disallow: /misc.php

- Disallow: /connect.php

- Disallow: /forum.php?mod=redirect*

- Disallow: /forum.php?mod=post*

- Disallow: /home.php?mod=spacecp*

- Disallow: /userapp.php?mod=app&*

- Disallow: /*?mod=misc*

- Disallow: /*?mod=attachment*

- Disallow: /*mobile=yes*

- User-agent: AhrefsBot

- Disallow: /

- User-agent: AhrefsBot/6.1

- Disallow: /

- User-agent: BLEXBot

- Disallow: /

- User-agent: BLEXBot/1.0

- Disallow: /

- User-agent: CheckMarkNetwork

- Disallow: /

- User-agent: CCBot

- Disallow: /

- User-agent: DotBot

- Disallow: /

- User-agent: DoCoMo Spider

- Disallow: /

- User-agent: Ezooms/1.0

- Disallow: /

- User-agent: Mail.RU_Bot

- Disallow: /

- User-agent: MauiBot

- Disallow: /

- User-agent: MegaIndex.ru

- Disallow: /

- User-agent: MJ12bot

- Disallow: /

- User-agent: MJ12bot/v1.4.8

- Disallow: /

- User-agent: SemrushBot

- Disallow: /

- User-agent: SemrushBot/6~bl

- Disallow: /

- User-agent: spbot

- Disallow: /

- User-agent: SeznamBot

- Disallow: /

- User-agent: YandexBot

- Disallow: /

- User-agent: EasouSpider

- Disallow: /

复制代码

======================

宝塔双11活动预热 组队抢nginx防火墙

28元半年专业版 http://t.cn/Ai34aQbZ

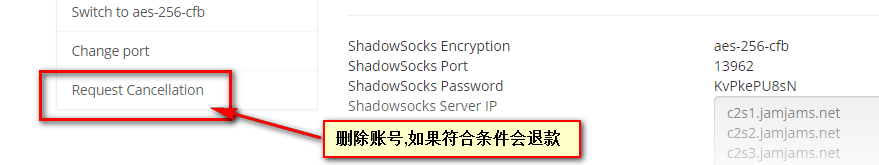

香港网友:谢谢大佬,头像很赞

黑龙江网友:几只蜘蛛都能把网站爬的跑不动,这得是什么样的配置啊!

江苏网友:个人小博客,一核心

安徽网友:我用nginx屏蔽

上海网友:我感觉应该用robots不允许它,然后在拉黑这些蜘蛛的ip段

四川网友:我跟你说 他们并不一定遵守这个 还需要屏蔽他的IP段最好 用xx.xx.xx.0/24 这几家的蜘蛛IP就IP并不多。

贵州网友:robots就行了 又不是国产的百度

天津网友:

已执行此命令

吉林网友:

已执行此命令

湖南网友:你要的是这个,直接UA屏蔽

https://www.yunloc.com/763.html

上海网友:这还用屏蔽。。。。

本来就没几个串门的

另外就跟前面大佬说的一样,几个蜘蛛网站就卡,配置得多差

未经允许不得转载:美国VPS_搬瓦工CN2 GIA VPS » 屏蔽国外蜘蛛爬行,这个robots该怎么写呢?

美国VPS_搬瓦工CN2 GIA VPS

美国VPS_搬瓦工CN2 GIA VPS

腾讯云轻量怎么购买,云轻量香港/美国/新加坡购买教程

腾讯云轻量怎么购买,云轻量香港/美国/新加坡购买教程 亏了,刚才退款了一个greencloud日本

亏了,刚才退款了一个greencloud日本

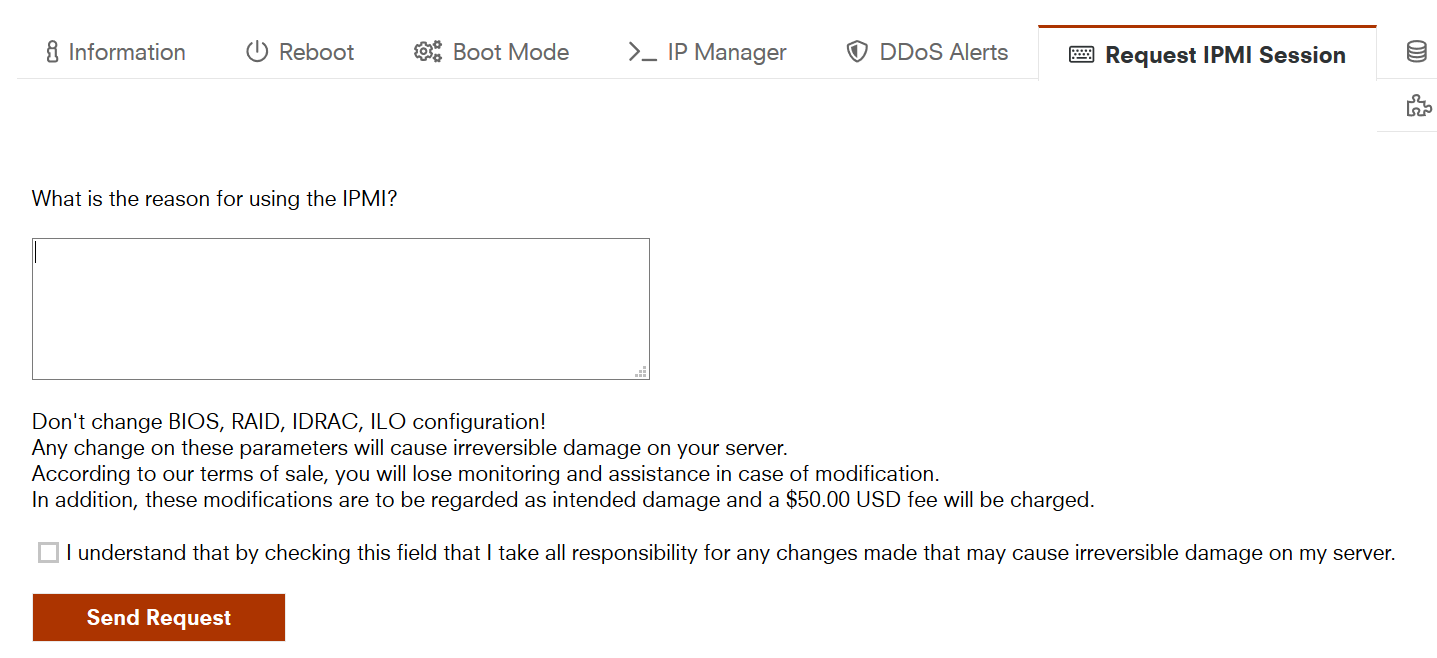

10欧的IPMI写什么申请理由好?

10欧的IPMI写什么申请理由好?