大佬们好,小白一个,站点把robots.txt设置了国内主流搜索引擎抓取,其他屏蔽。但总是有不遵守规则的爬虫弄得vps占用过高,怎么能屏蔽爬虫呢?有什么工具吗?我的是lnmp环境,小弟不胜感激

台湾网友:服务器反爬虫攻略 Apache/Nginx/PHP禁止非法抓取内容

https://www.yunloc.com/763.html

吉林网友:增长ip卖广告,也挺好的啊

甘肃网友:谢谢大佬,我去看看可不可行

山东网友:性能都被占用了,增长的ip没什么用,全是爬虫

湖南网友:我是抓到直接ban IP. emm 抓了几十个 爬虫就越来越少了.

上海网友:爬虫占用不了多少性能吧?

除非疯狂采集?

安徽网友:有几个拼命的抓,cpu好几次占用100%

贵州网友:根据ua或ip添加屏蔽规则 可以堵住不少

澳门网友:

根据ip限流下好了 ,

搞个令牌桶,比如限制单ip1分钟最多x次.

话说楼主什么站?

发出来让mjj们ip+1一下

天津网友:

根据ip限流下好了 ,

搞个令牌桶,比如限制单ip1分钟最多x次.

话说楼主什么站?

发出来让mjj们ip+1一下

广西网友:根据ua拦截不靠谱,很多不规矩的东西现在都会伪装成baiduspider。

贵州网友:确实,说来说去还是VPS性能差了。。。

我的轻量香港24的每天谷歌10W的蜘蛛,偶尔也502或者CPU百分百,

高配ks3c,真的无压力….

四川网友: List of IP addresses of Known Web Bots & Spiders

https://myip.ms/files/bots/live_webcrawlers.txt

未经允许不得转载:美国VPS_搬瓦工CN2 GIA VPS » 怎么屏蔽不遵守规则的爬虫?

美国VPS_搬瓦工CN2 GIA VPS

美国VPS_搬瓦工CN2 GIA VPS

腾讯云轻量怎么购买,云轻量香港/美国/新加坡购买教程

腾讯云轻量怎么购买,云轻量香港/美国/新加坡购买教程 亏了,刚才退款了一个greencloud日本

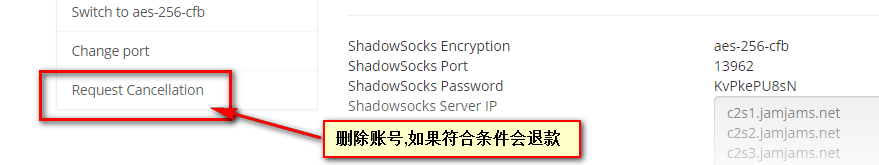

亏了,刚才退款了一个greencloud日本

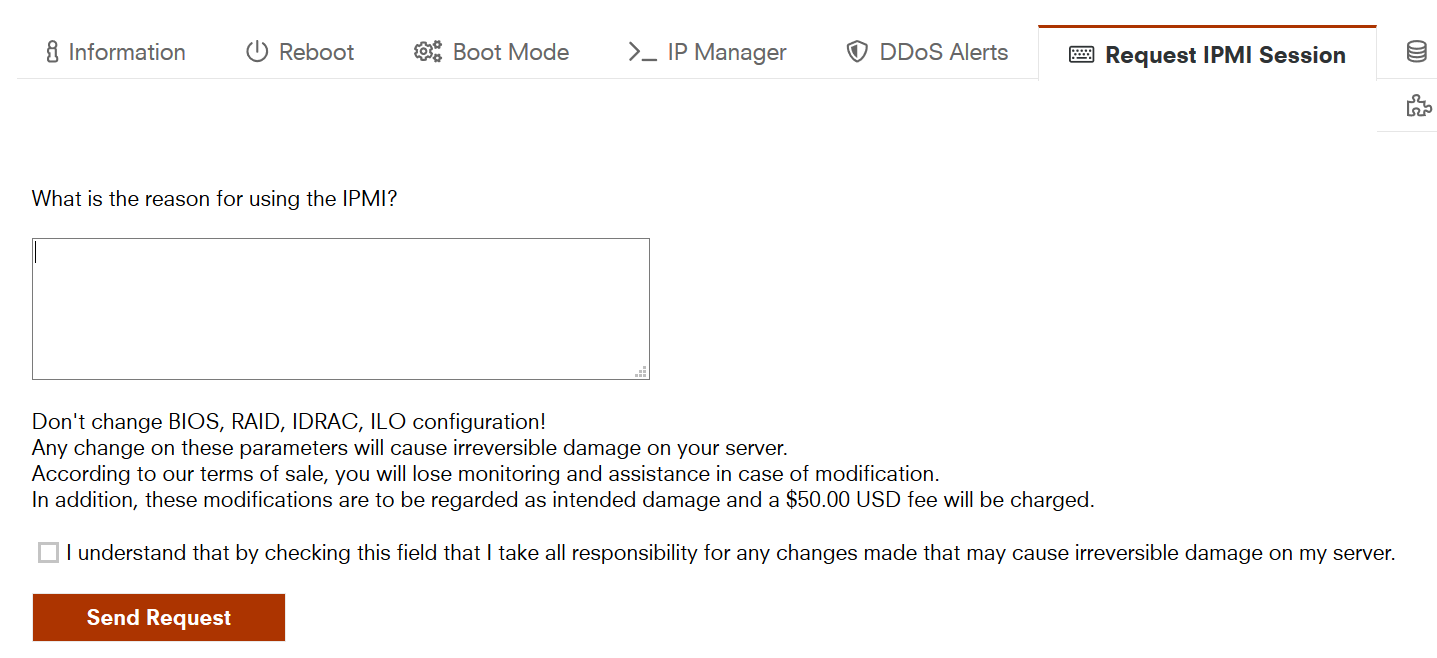

10欧的IPMI写什么申请理由好?

10欧的IPMI写什么申请理由好?