采集了200W条数据,字段有id,title等,入库时title没设置唯一,怎么能快速基于title去重,去重后我要设置title唯一,才敢再采集入库

贵州网友:新建一个表,加主键,导过去,忽略失败。

天津网友:用个redis做缓存,一边读,一边判断,再写到一个新库里得了。200万,用不了多久。

湖南网友:才200万,导出来设置唯一索引再导入进去就行了

甘肃网友:简单粗暴有效的做法

澳门网友:给跪了,,,但是不做好备份,出错就gg

贵州网友:解决问题就是要这样

内蒙古网友:我又不动原数据,出错怎么就gg了呢

新疆网友:

- use database;

- drop table tablename;

- commit;

复制代码

黑龙江网友:

命令要写全啊。

- use database;

- drop table tablename;

- commit;

- # run away

复制代码

吉林网友:

命令要写全啊。

- use database;

- drop table tablename;

- commit;

- # run away

复制代码

西藏网友:不是我写的。

广西网友:不好意思,在问一下。用什么语句导呢?insert into B select * from A;遇到重复就报错停止了

北京网友:自己查到了,用insert ignore into B select * from A;可以

未经允许不得转载:美国VPS_搬瓦工CN2 GIA VPS » Mysql百万数据去重

美国VPS_搬瓦工CN2 GIA VPS

美国VPS_搬瓦工CN2 GIA VPS

腾讯云轻量怎么购买,云轻量香港/美国/新加坡购买教程

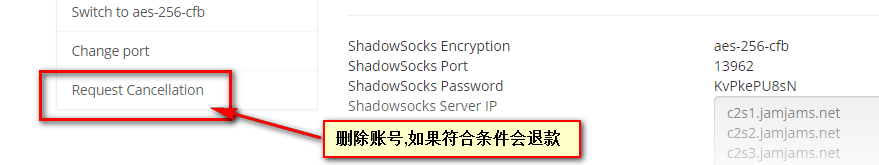

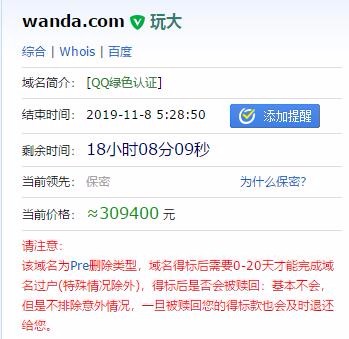

腾讯云轻量怎么购买,云轻量香港/美国/新加坡购买教程 亏了,刚才退款了一个greencloud日本

亏了,刚才退款了一个greencloud日本

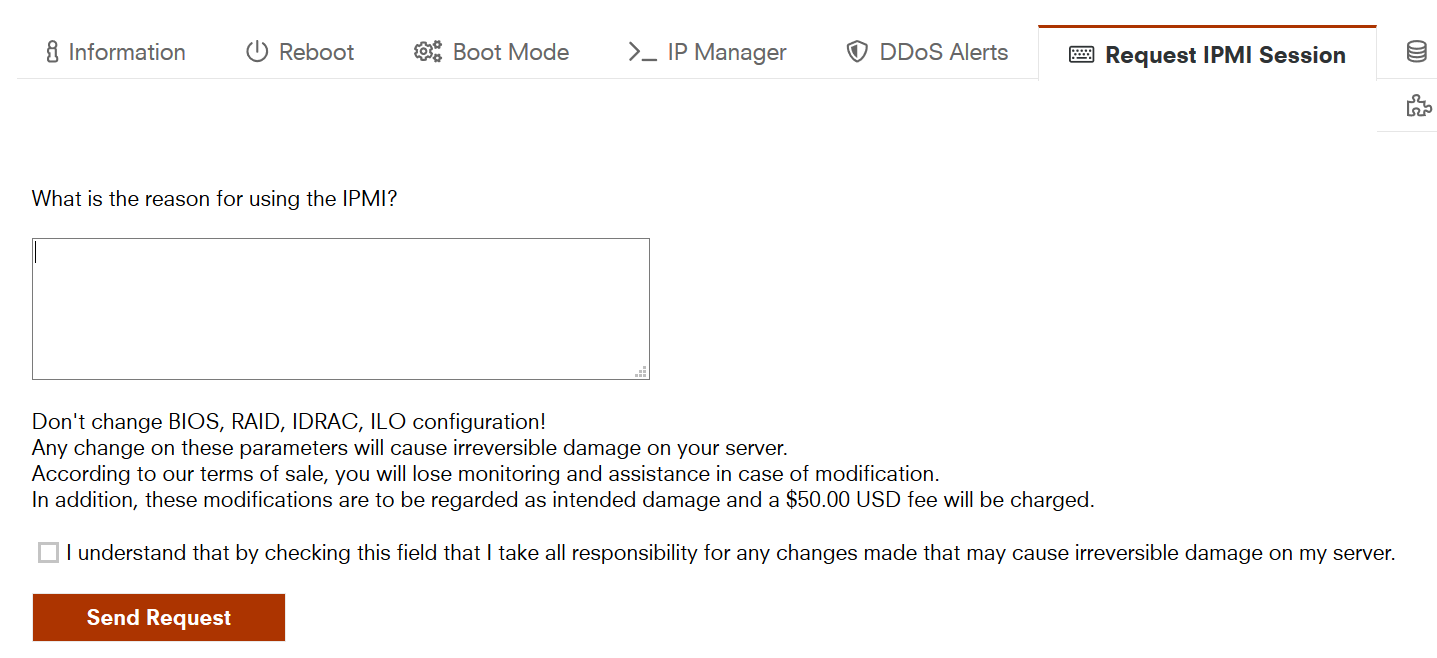

10欧的IPMI写什么申请理由好?

10欧的IPMI写什么申请理由好?